在人工智能领域,大型语言模型 (LLM) 正迅速成为一股不可忽视的力量。它们能够理解和生成人类语言,并在各种应用中展现出惊人的能力,例如文本生成、机器翻译、代码编写等等。然而,使用这些强大的模型通常依赖于云服务提供商,这引发了人们对数据隐私、安全性和成本的担忧。

为了解决这些问题,LocalAI 应运而生。这是一个开源项目,旨在让用户能够在本地机器上运行 LLM,而无需依赖任何外部服务。通过 LocalAI,您可以在自己的硬件上部署和使用各种流行的 LLM,并完全掌控您的数据和模型。

1. LocalAI 是什么?

LocalAI 是一个用 Go 语言编写的开源 REST API,它兼容 OpenAI API 规范,可以用作 OpenAI API 的直接替代品。它允许您在本地 CPU 或 GPU 上运行各种开源 LLM,包括基于 llama.cpp、gpt4all 等后端的模型。LocalAI 的核心目标是提供一个简单、灵活且可扩展的平台,让每个人都能轻松地在本地使用 LLM。

2. 为什么选择 LocalAI?

-

隐私和数据安全: LocalAI 的最大优势在于它完全在本地运行,这意味着您的数据永远不会离开您的机器。这对于处理敏感信息或关注数据隐私的用户来说至关重要。

-

成本效益: 与依赖云服务的 LLM API 相比,LocalAI 可以显著降低成本,特别是对于高频使用场景。您只需支付硬件成本,无需按请求次数或令牌数量付费。

-

灵活性和可定制性: LocalAI 支持多种 LLM 后端和模型,您可以根据自己的需求选择最合适的模型。此外,它还支持模型微调和定制,您可以根据特定任务优化模型性能。

-

离线使用: LocalAI 可以在没有互联网连接的情况下运行,这使得它非常适合在网络受限或离线环境中部署和使用。

-

社区支持: LocalAI 拥有一个活跃的开源社区,您可以轻松获得帮助、分享经验并参与项目开发。

-

简单易用: LocalAI 提供了简洁的 API 和清晰的文档,即使是初学者也能轻松上手。

3. LocalAI 的核心功能:

-

支持多种 LLM 后端: LocalAI 支持多种流行的 LLM 后端,例如:

-

llama.cpp: 这是 Meta AI 的 LLaMA 模型的 C++ 实现,以其高效和低资源消耗而闻名。

-

gpt4all: 一个允许在本地运行各种 LLM 的项目,支持多种模型格式。

-

ggml: 一种用于机器学习的张量库,旨在实现高效的 CPU 推理。

-

rwkv.cpp: RWKV 模型的 C++ 实现,RWKV 是一种基于 RNN 的架构,在长文本生成方面表现出色。

-

-

兼容 OpenAI API: LocalAI 的 API 与 OpenAI API 兼容,这意味着您可以轻松地将现有的基于 OpenAI 的应用程序迁移到 LocalAI,而无需进行大量代码修改。

-

模型加载和管理: LocalAI 提供了简单的命令和 API 来加载和管理不同的模型。您可以轻松地在不同的模型之间切换,并指定要使用的模型版本。

-

文本生成: LocalAI 的核心功能之一是文本生成。您可以通过 API 向模型提供提示,并获取模型生成的文本响应。

-

嵌入生成: LocalAI 支持生成文本嵌入,这对于文本相似性比较、语义搜索等任务非常有用。

-

图像生成(即将推出): LocalAI 正在积极开发图像生成功能,这将进一步扩展其应用场景。

-

音频转录(即将推出): 支持音频转录功能,让LocalAI可以处理音频数据。

4. 如何开始使用 LocalAI?

LocalAI 提供了多种安装和使用方式:

-

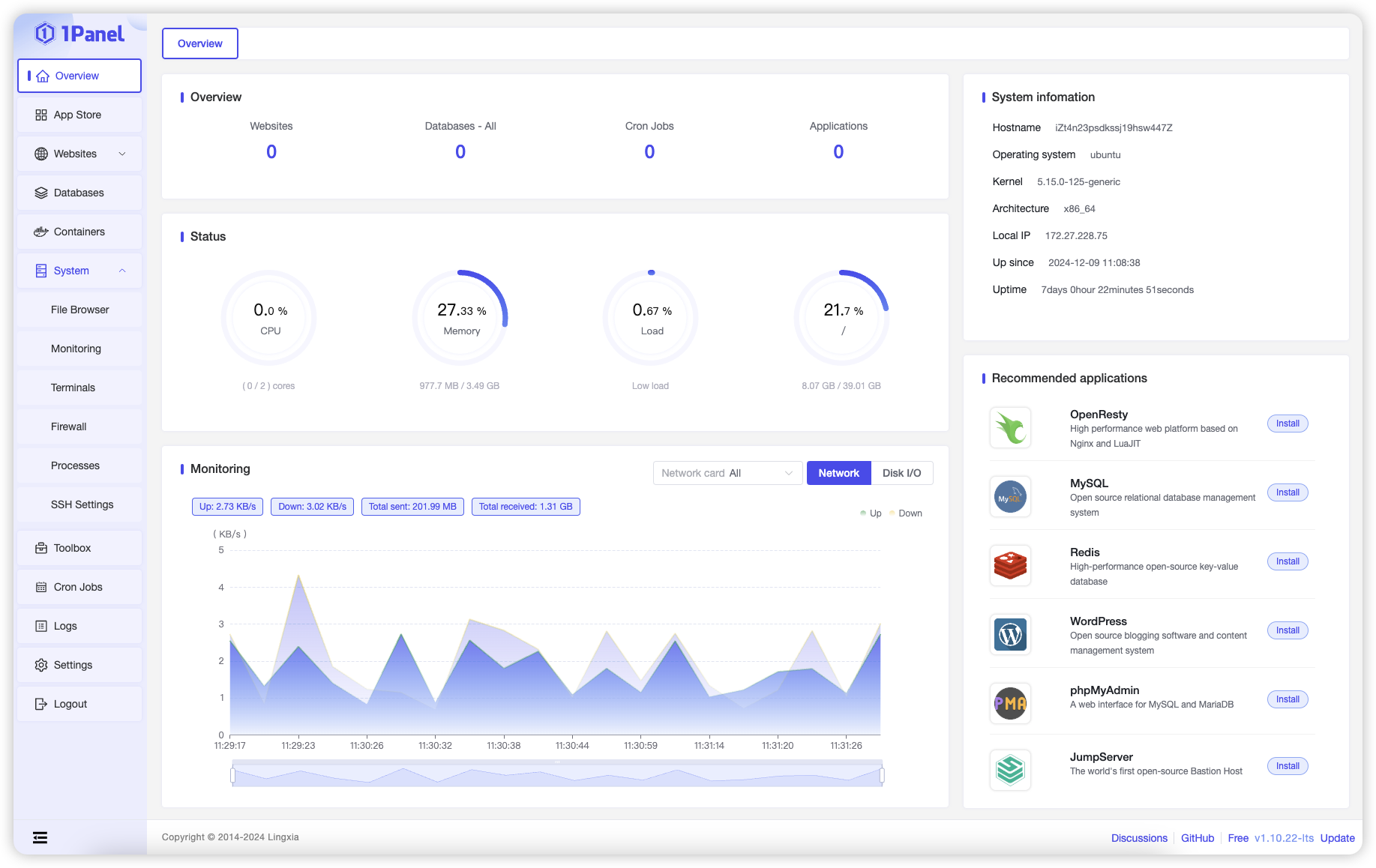

Docker: 使用 Docker 部署 LocalAI 是最简单和推荐的方式。您只需拉取官方 Docker 镜像并运行容器即可。

-

二进制文件: 您可以从 GitHub 仓库下载预编译的二进制文件,并直接在您的系统上运行。

-

从源码编译: 对于高级用户,您可以从源码编译 LocalAI,以便进行更深入的定制和优化。

LocalAI 的 GitHub 仓库提供了详细的文档和示例,帮助您快速上手。

5. LocalAI 的应用场景:

LocalAI 具有广泛的应用场景,包括但不限于:

-

聊天机器人: 构建个性化的聊天机器人,用于客户服务、教育或娱乐。

-

内容生成: 自动生成文章、博客、社交媒体帖子等内容。

-

代码辅助: 利用 LLM 进行代码补全、代码生成和代码审查。

-

文本摘要: 从长文本中提取关键信息,生成简洁的摘要。

-

机器翻译: 在本地进行机器翻译,保护翻译内容的隐私。

-

数据分析: 利用 LLM 分析文本数据,提取见解和模式。

6. LocalAI 与竞争对手的比较:

市面上还有其他一些开源项目也致力于在本地运行 LLM,例如:

-

Ollama: 一个专注于易用性和 macOS 集成的项目。

-

Text Generation WebUI: 一个基于 Gradio 的 Web 界面,用于运行和管理各种 LLM。

与这些项目相比,LocalAI 的优势在于其对 OpenAI API 的兼容性、对多种后端的支持以及更强的可扩展性和灵活性。

394914567

394914567

@code0739

@code0739